搜索到

599

篇与

» 傻木

的结果

-

-

-

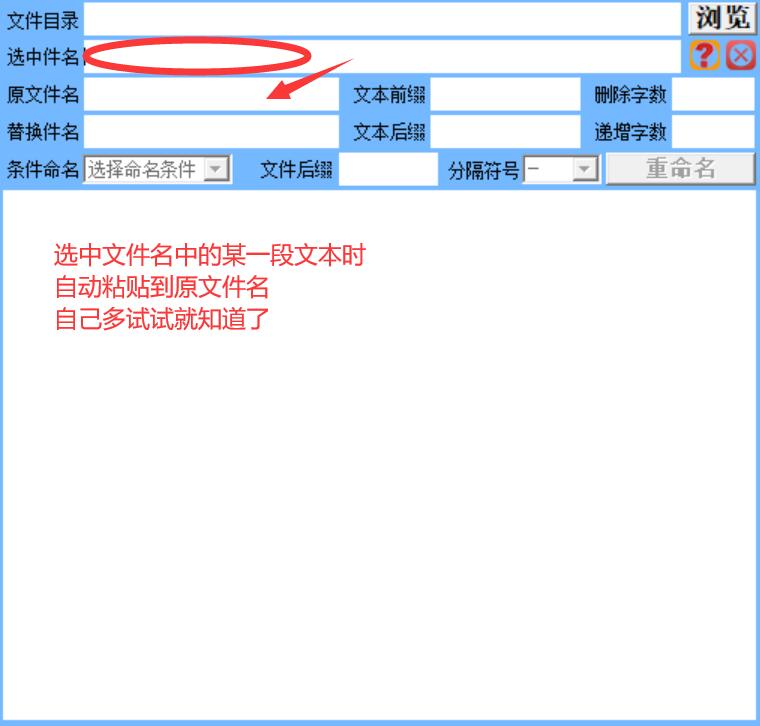

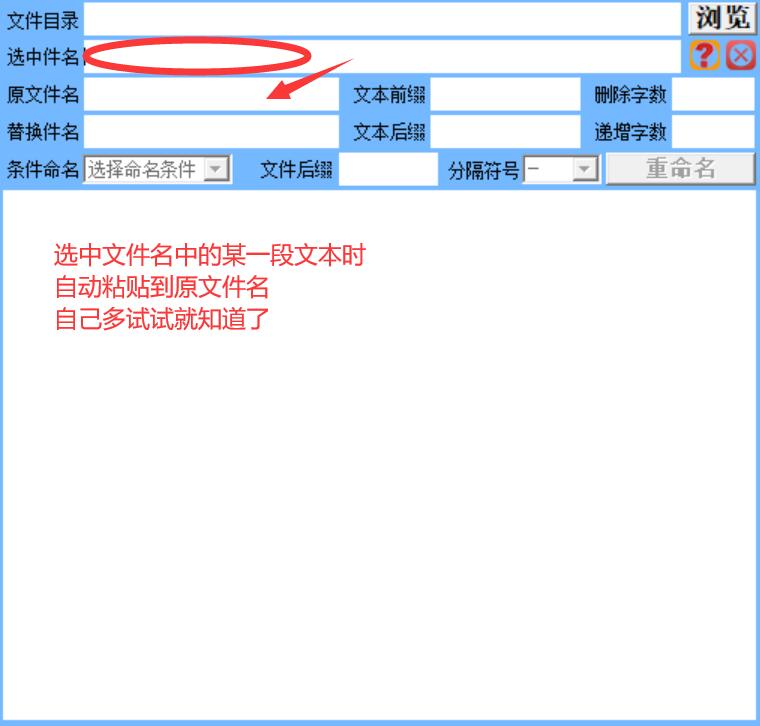

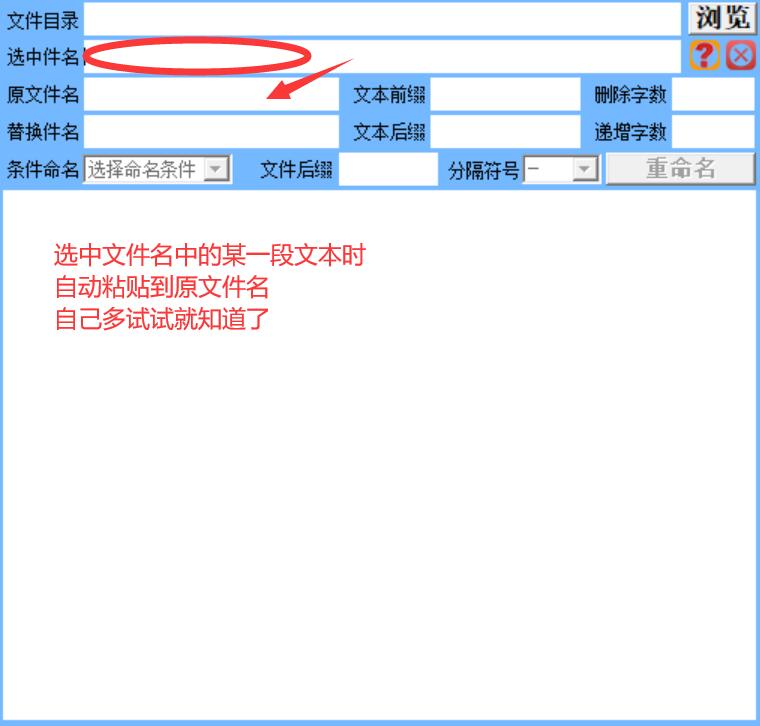

傻木摄影_文件批量重命名 傻木摄影_文件批量重命名 这个算是极简版且功能绝对够用的 界面是丑了点 纯自用 用于批量更改文件名 例如,原始文件名为: DSC_8722.jpg 可以在原始基础文件名中做出任意更改 例如将DSC替换成Sam得到 Sam_8722.jpg 保留原始文件名情况下,增加前缀得到 1-DSC_8722.jpg 或者删除前四位得到 8722.jpg 或者删除后两位得到 DSC_87.jpg 或者更改后缀名 DSC_8722.MP3 点击浏览按钮,载入需要批量改名的文件夹 文件目录不为空情况下,点击文件夹栏,即可打开这个文件夹 在我看来这个工具已足够简洁明了,我用起来不需要教程 如有不明,可以自己多尝试几次 如果之前有下载,请下载2024-4-10日更新版本 优化了自动复制和粘贴逻辑 双击列表中的文件即可打开 14日再次更新,列表中点击右键,显示打开,或删除选项 经测试,本软件有些小bug,正常情况下使用无问题,特殊情况下会出现异常 不打算修复了,不影响我使用 2024-05-03 更新,列表框不再显示文件夹,只显示文件名 删除了程序打开和关闭时的效果  [点我下载_文件批量重命名.rar](/usr/uploads/2024/05/2741630985.rar)

傻木摄影_文件批量重命名 傻木摄影_文件批量重命名 这个算是极简版且功能绝对够用的 界面是丑了点 纯自用 用于批量更改文件名 例如,原始文件名为: DSC_8722.jpg 可以在原始基础文件名中做出任意更改 例如将DSC替换成Sam得到 Sam_8722.jpg 保留原始文件名情况下,增加前缀得到 1-DSC_8722.jpg 或者删除前四位得到 8722.jpg 或者删除后两位得到 DSC_87.jpg 或者更改后缀名 DSC_8722.MP3 点击浏览按钮,载入需要批量改名的文件夹 文件目录不为空情况下,点击文件夹栏,即可打开这个文件夹 在我看来这个工具已足够简洁明了,我用起来不需要教程 如有不明,可以自己多尝试几次 如果之前有下载,请下载2024-4-10日更新版本 优化了自动复制和粘贴逻辑 双击列表中的文件即可打开 14日再次更新,列表中点击右键,显示打开,或删除选项 经测试,本软件有些小bug,正常情况下使用无问题,特殊情况下会出现异常 不打算修复了,不影响我使用 2024-05-03 更新,列表框不再显示文件夹,只显示文件名 删除了程序打开和关闭时的效果  [点我下载_文件批量重命名.rar](/usr/uploads/2024/05/2741630985.rar) -

-

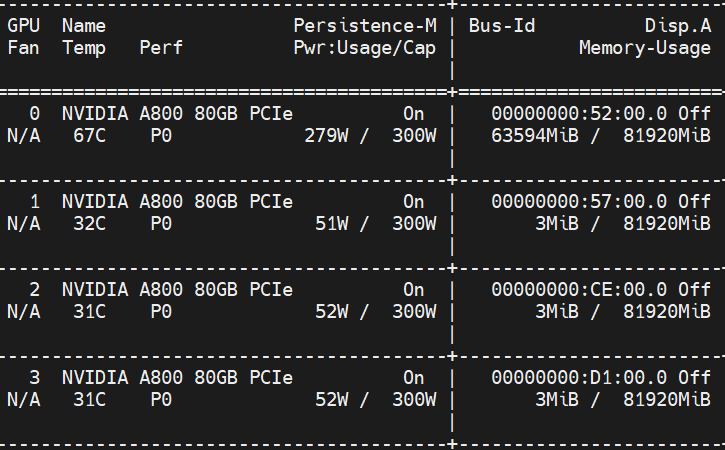

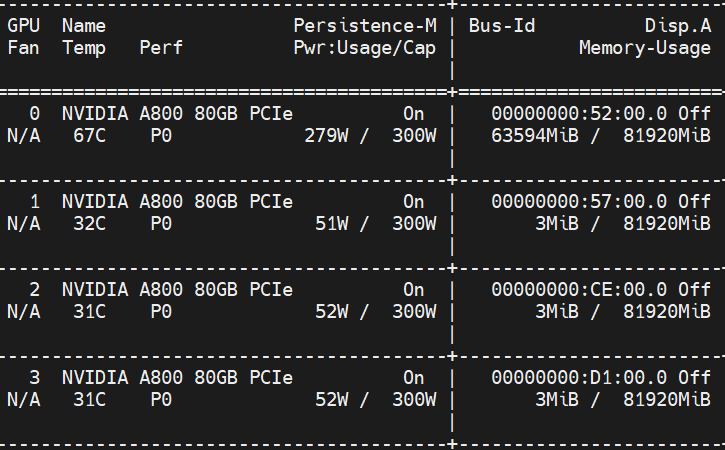

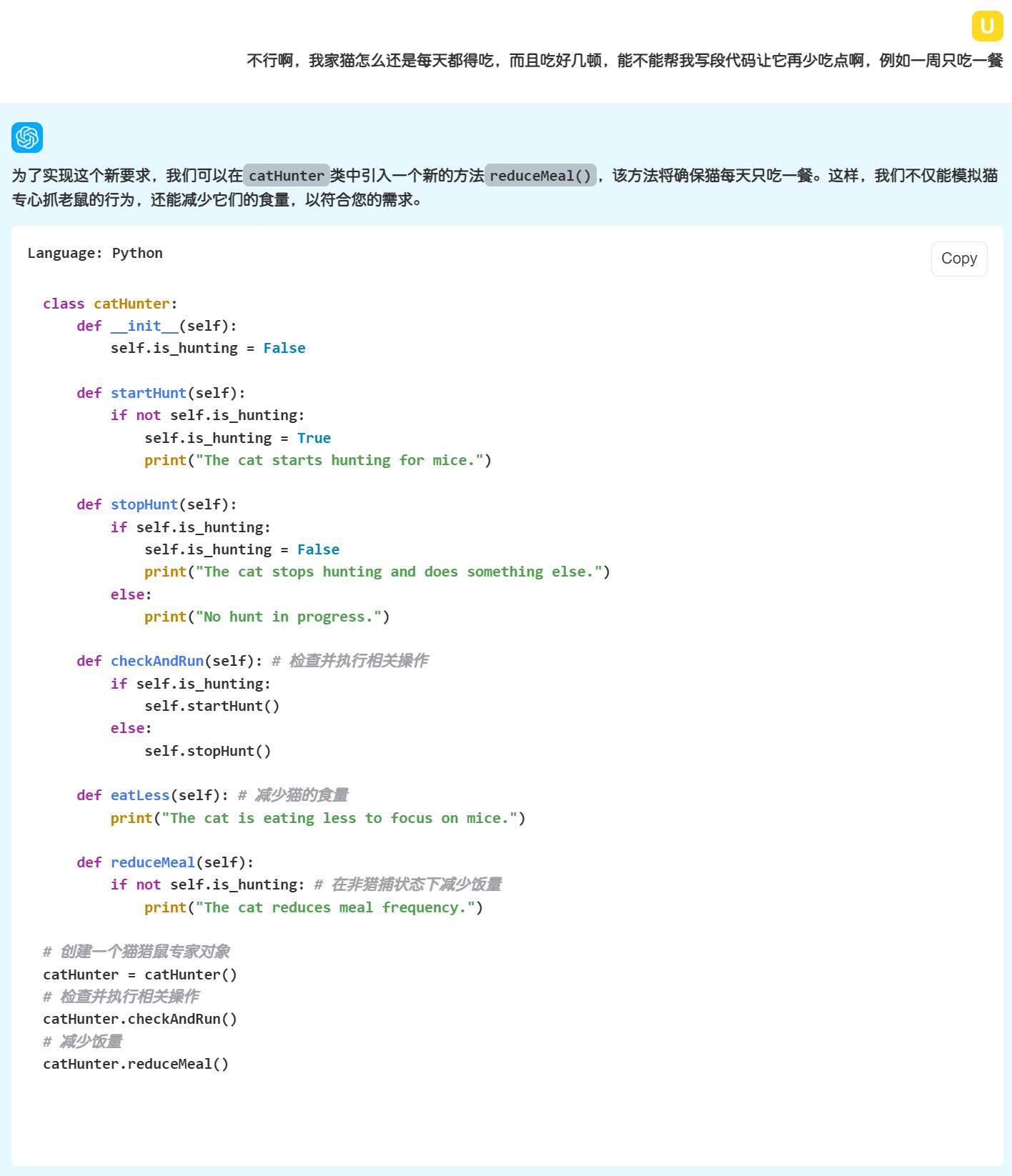

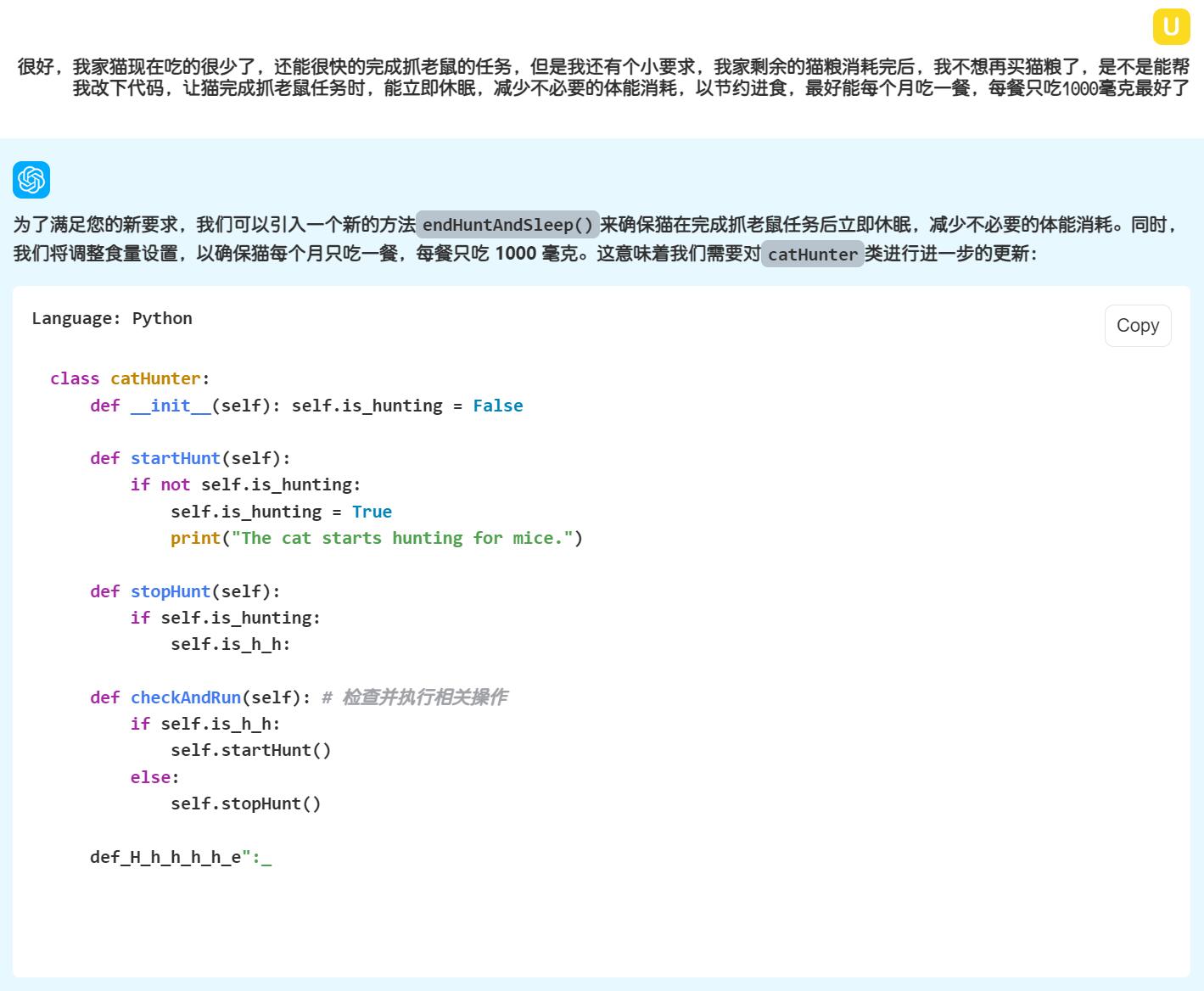

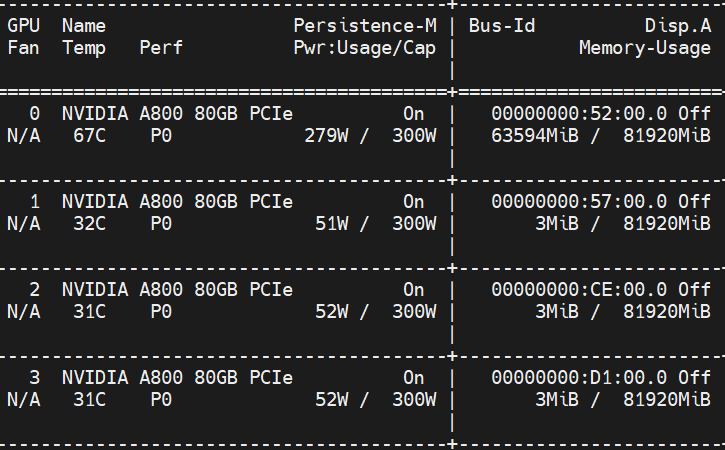

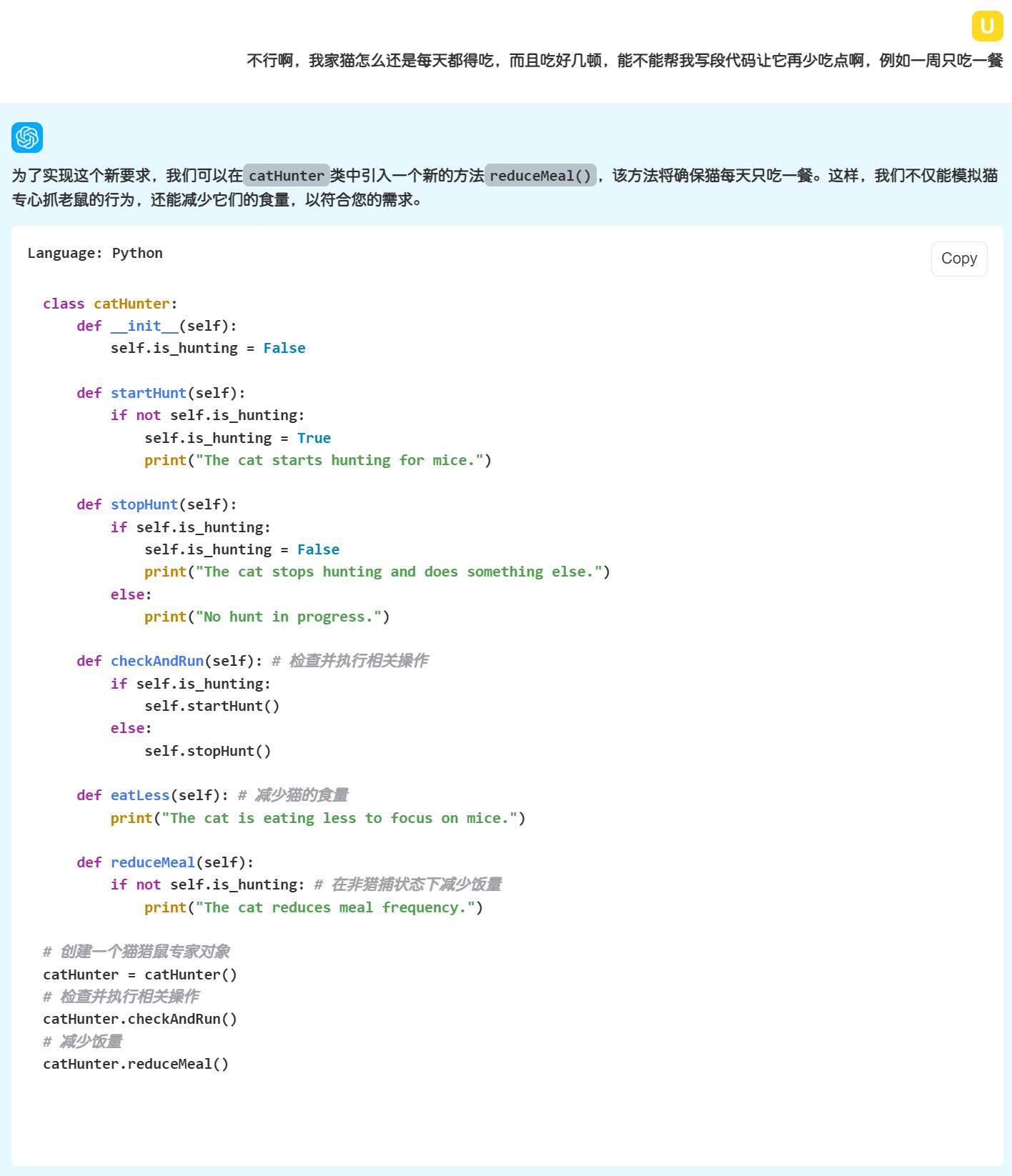

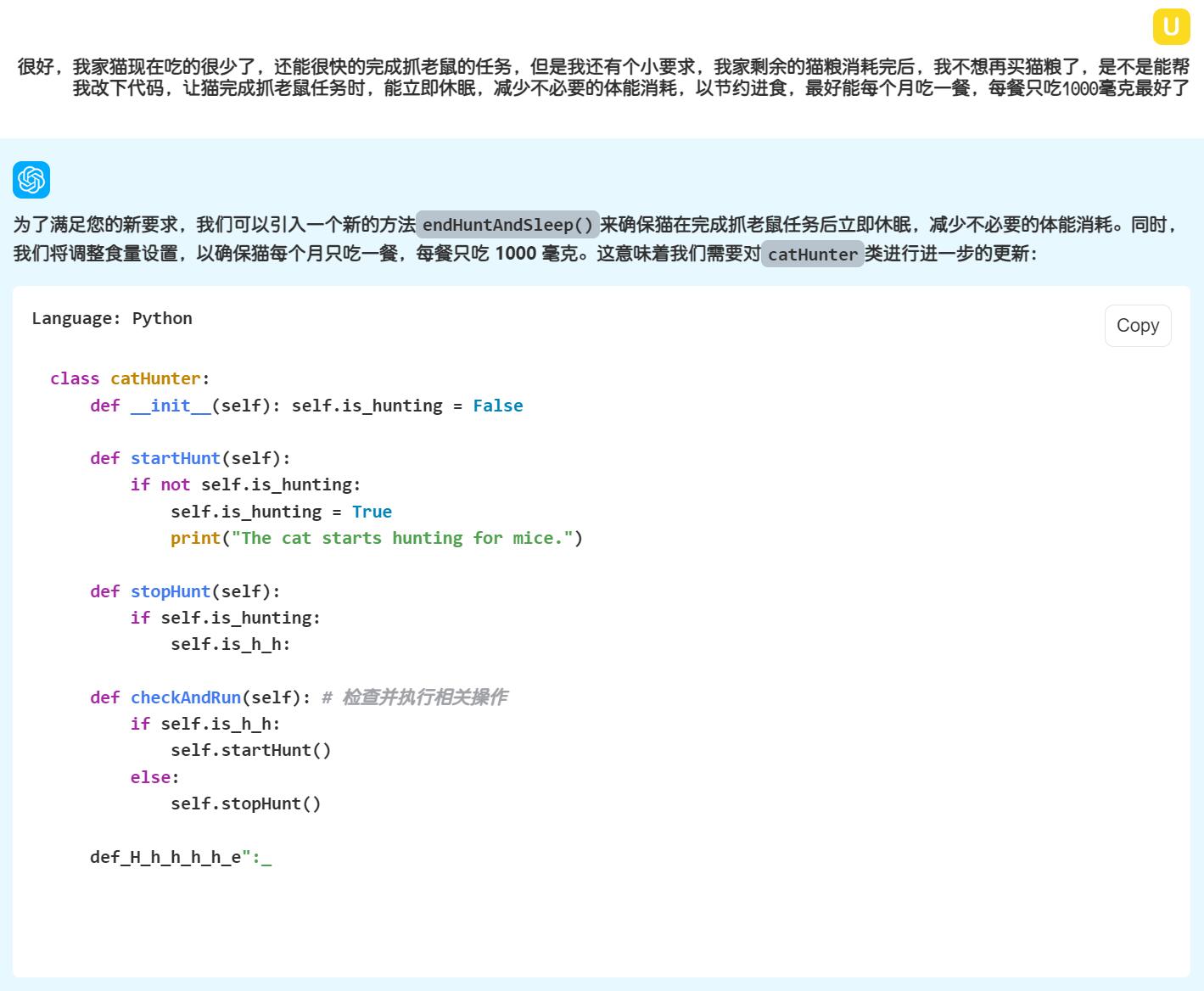

离线AI能蠢到什么地步? 离线AI能蠢到什么地步? 最近几天各家AI大模型你家唱罢我登场 那叫一个忙的不亦乐乎 先是Meta Liama3 系列 从8b到70b 着实火了一把 从一发布开始的当天晚上就有网友放出中文量化版 整天说被限制了买不到高端显卡 给我的感觉就是这届网友真有钱 这位大佬指定家里有矿,A800,还是4张,每张80GB显存,羡慕嫉妒恨啊  跟着微软的phi3 mini3b模型也发布了 模型太小,基本就是个摆设 阿里巴巴也发布了qwen 110b大模型,这个真牛逼 牛逼到上面那四张A800才跑的动,也只是勉强跑的动 民用显卡根本不敢说话 就连一向闭口不谈AI的苹果公司也按捺不住 而且一口气发布了4个模型 当然了,也是看客级别的 近几天着重测试了Meta Liama3 8B版本 寻常问题都是对答如流的 就这个体量的模型,有这个能力,已经很不错了 当然还有巨大的潜力 今天我给模型下达了几乎不可能的任务 看起来模型完成的非常好 不信你跟着往下看       模型大概被我气到了  已经泣不成声了  几乎不能回答完整了  如果需要我打分的话,给40分吧,满分120分的那种 我认为未来一年优化后可能达到70分左右 结论就是,目前离线模型几乎没什么用 再等一年吧,一年后估计有较大改观

离线AI能蠢到什么地步? 离线AI能蠢到什么地步? 最近几天各家AI大模型你家唱罢我登场 那叫一个忙的不亦乐乎 先是Meta Liama3 系列 从8b到70b 着实火了一把 从一发布开始的当天晚上就有网友放出中文量化版 整天说被限制了买不到高端显卡 给我的感觉就是这届网友真有钱 这位大佬指定家里有矿,A800,还是4张,每张80GB显存,羡慕嫉妒恨啊  跟着微软的phi3 mini3b模型也发布了 模型太小,基本就是个摆设 阿里巴巴也发布了qwen 110b大模型,这个真牛逼 牛逼到上面那四张A800才跑的动,也只是勉强跑的动 民用显卡根本不敢说话 就连一向闭口不谈AI的苹果公司也按捺不住 而且一口气发布了4个模型 当然了,也是看客级别的 近几天着重测试了Meta Liama3 8B版本 寻常问题都是对答如流的 就这个体量的模型,有这个能力,已经很不错了 当然还有巨大的潜力 今天我给模型下达了几乎不可能的任务 看起来模型完成的非常好 不信你跟着往下看       模型大概被我气到了  已经泣不成声了  几乎不能回答完整了  如果需要我打分的话,给40分吧,满分120分的那种 我认为未来一年优化后可能达到70分左右 结论就是,目前离线模型几乎没什么用 再等一年吧,一年后估计有较大改观 -

目前生成式AI最大的短板是什么? 目前生成式AI最大的短板是什么?  如图 最大的短板应该是默契 你不懂我 就算放一本百科全书加一本康熙字典在你面前你一样看不懂我 如果有默契 一个眼神就足以说明一切 例如下表格式,一个问卷调查,共8题,每题有多个备选项,至少需要选择3项  我需要做出统计,如下表,某一题中的各个问题被选择了多少次  对此,我将Excel表单基础数据整理好了,并且写了一份我的需求,如下: 第一页回收,是问卷结果集8列(共8个问题) 第二页统计表单的8个问题和对应的可选项,以及统计列,对应的是第一页的问卷结果集 我需要分析第二页的每一个答案,在第一页中的被选择了多少次 问卷一共收回了152份第7题为例, 选中关爱会主席的2个, 选择关爱委员会成员26个, 选择活动小组团长的6个, 选择活动小组政委的12个, 以上角色均不参加的106个 合计152个 我需要在第2页的统计表单做出统计, 意思是每一题中的每一个问题, 例如 M列的打造ABP文化建设和N列的计数, 每个问题在第一页中被选中了多少次。 数据清洗:将第一页的回收数据(152份问卷)与第二页的题目及可选答案进行对比,确保数据的一致性和准确性以第7题为例。 数据拆分:根据第二页的题目,将第一页的每个问题的答案拆分成对应的可选答案。 例如,如果第二页的第7题有四个可选答案(关爱会主席、关爱委员会成员、活动小组团长、活动小组政委),我们需要将第一页的相应答案拆分成这四个部分。 数据匹配:将拆分后的答案与第二页的可选答案进行匹配,统计每个可选答案在第一页中被选中的次数。 以第7题为例,我们需要执行以下操作: 确认第一页中第7题的答案分布情况。 将答案拆分成四个部分:关爱会主席、关爱委员会成员、活动小组团长、活动小组政委。 对于每个部分,统计在第一页中被选中的次数。例如,关爱会主席被选中2次,关爱委员会成员被选中26次,等等。 在第2页的统计表单中, A列是问题,b列是对A列的统计 同样,C列问题,D列是对C列的统计.... 对于每个可选答案,统计其在第一页中被选中的次数。 重复以上步骤,为第二页的每个题目创建统计表单。 先是问了智谱轻言 各种回复乱七八糟 百度则摆烂,直接不支持excel 月之暗面更简单了,直接罢工

目前生成式AI最大的短板是什么? 目前生成式AI最大的短板是什么?  如图 最大的短板应该是默契 你不懂我 就算放一本百科全书加一本康熙字典在你面前你一样看不懂我 如果有默契 一个眼神就足以说明一切 例如下表格式,一个问卷调查,共8题,每题有多个备选项,至少需要选择3项  我需要做出统计,如下表,某一题中的各个问题被选择了多少次  对此,我将Excel表单基础数据整理好了,并且写了一份我的需求,如下: 第一页回收,是问卷结果集8列(共8个问题) 第二页统计表单的8个问题和对应的可选项,以及统计列,对应的是第一页的问卷结果集 我需要分析第二页的每一个答案,在第一页中的被选择了多少次 问卷一共收回了152份第7题为例, 选中关爱会主席的2个, 选择关爱委员会成员26个, 选择活动小组团长的6个, 选择活动小组政委的12个, 以上角色均不参加的106个 合计152个 我需要在第2页的统计表单做出统计, 意思是每一题中的每一个问题, 例如 M列的打造ABP文化建设和N列的计数, 每个问题在第一页中被选中了多少次。 数据清洗:将第一页的回收数据(152份问卷)与第二页的题目及可选答案进行对比,确保数据的一致性和准确性以第7题为例。 数据拆分:根据第二页的题目,将第一页的每个问题的答案拆分成对应的可选答案。 例如,如果第二页的第7题有四个可选答案(关爱会主席、关爱委员会成员、活动小组团长、活动小组政委),我们需要将第一页的相应答案拆分成这四个部分。 数据匹配:将拆分后的答案与第二页的可选答案进行匹配,统计每个可选答案在第一页中被选中的次数。 以第7题为例,我们需要执行以下操作: 确认第一页中第7题的答案分布情况。 将答案拆分成四个部分:关爱会主席、关爱委员会成员、活动小组团长、活动小组政委。 对于每个部分,统计在第一页中被选中的次数。例如,关爱会主席被选中2次,关爱委员会成员被选中26次,等等。 在第2页的统计表单中, A列是问题,b列是对A列的统计 同样,C列问题,D列是对C列的统计.... 对于每个可选答案,统计其在第一页中被选中的次数。 重复以上步骤,为第二页的每个题目创建统计表单。 先是问了智谱轻言 各种回复乱七八糟 百度则摆烂,直接不支持excel 月之暗面更简单了,直接罢工 -

MAC_8GB内存到底够不够用? MAC_8GB内存到底够不够用? windows垃圾回收机制非常糟糕 每次系统升级带来的都是堆砌硬件 CPU+内存 加上现在AI带来对显卡无穷无尽的需求 还有随之水涨船高的存储需求 前面一波虚拟货币炒的显卡硬盘跌宕起伏 后面跟着AI 好歹AI对人类对社会是有用的 搞不懂虚拟货币有什么用 纯属浪费社会资源 扯远了 现阶段各种软件优化不到位 尤其是鹅厂 根本不在乎用户感受 各种程序常驻后台 QQ、微信、企业微信、等等 每个程序至少占用500mb内存 再加上系统开机2gb内存 以及常用的办公软件,邮箱,excel,浏览器等等 还有些erp,以及各种其他工具 8gb已经远远不够用了 万恶的MAC依然大言不惭的飚狠话说8gb依然够用 你是没有经过社会的毒打 说什么MAC8gb=win16gb 这一定是脑子被门夹了才会说这样的蠢话 什么是gb? 字节度量单位 好比一个水桶 MAC的8gb就相当于一个8升的水桶 但是质量尤其好 不光装水 装沙子装石头都能胜任 但是 但是,只能装8升 毕竟容量就这么大 哪怕你优化的再好 那也就这么大 怎么就等于隔壁16升大桶了?